التحديات التّسع لمواجهة تعلم الآلة… هل يمكننا خداع الآلة؟

من المحتمل أن يكون المستقبل رائعًا، ولكن في وقتنا الحالي يطرح الذكاء الاصطناعي (AI) بعض الأسئلة المقلقة وغالبًا ما يتعلق الأمر بالأمور الأخلاقية. ستفاجئنا تعلم الآلة بالفعل، و الأمر المهم هو هل يمكننا أن نواجهها أو أن نقوم بخداعها؟ وإذا كان الأمر كذلك ما مدى صعوبة ذلك؟ وهل سينتهي الأمر كله مع Skynet وتفوق الآلات؟

سنحاول أن نجيب عن كل هذه التساؤلات في هذا المقال من خلال طرح تسع تحديات يجب أن نُجابهها وأن نتغلب عليها لنتجنب خطر تعلّم الآلة القريب.

الذكاء الاصطناعي القوي والضعيف

بداية نحتاج إلى التفريق بين المفهومين: الذكاء الاصطناعي القوي والضعيف. الذكاء الاصطناعي القوي هو آلة افتراضية قادرة على التفكير ومدركة لوجودها ولا يمكنها حل المهام المخصصة فحسب، بل يمكنها أيضًا تعلم أشياء جديدة.

أما الذكاء الاصطناعي الضعيف وهو المعروف والموجود في التطبيقات المصممة لحل مشاكل محددة، مثل التعرف على الصور وقيادة السيارة وما إلى ذلك. باختصار فإن الذكاء الاصطناعي الضعيف هو الشيء الذي نطلق عليه “تعلم الآلة”.

لا نعرف حتى الآن ما إذا كان يُمكن اختراع ذكاء اصطناعي قوي أم لا. وفقًا لاستطلاعات الخبراء، فسنضطر إلى الانتظار 45 عامًا أخرى. هذا حقًا يعني أن في يوم من الأيام القادمة، سيتم تسويق قوة الإندماج التي تعتبر من أقوى الطاقات النووية على الإطلاق والتي تمدنا بالحرارة، نور والحياة (وهو أساس الكون).

ما الخطأ الذي يمكن أن يحدث؟

لا يزال من غير الواضح متى سيتم تطوير الذكاء الاصطناعي القوي، لكن الذكاء الاصطناعي الضعيف موجود بالفعل منذ أعوام ويعمل جيدًا في العديد من المجالات وفي كل عام نراه يتقدم بخطوة جديدة. يتيح لنا تعلم الآلة التعامل مع المهام العملية بدون برمجة واضحة؛ يتعلم من الأمثلة.

يتم تعليم الآلات لغرض حل المشكلات الملموسة لحد الآن، لذا فإن النموذج الرياضي الناتج وما نسميه بـ “خوارزمية التعلم” لا يُمكنه فجأة تطوير الرغبة في إنقاذ البشرية، بعبارة أخرى يجب ألا نخاف من وضع Skynet بسبب الذكاء الاصطناعي الضعيف، لكن بعض الأشياء يمكن أن تسوء أكثر إذا أخطأنا الظن.

1. النوايا السيئة

إذا علمنا جيشًا من الطائرات بدون طيار قتل الناس باستخدام التعلم الآلي، هل يمكن أن تكون النتائج أخلاقية؟

ظهر خلاف عام 2017 حول هذا الموضوع بالذات، حيث كانت Google تعمل على تطوير برنامج يستخدم لمشروع عسكري يسمى Project Maven يتضمن في خططه طائرات بدون طيار لإنشاء أنظمة أسلحة مستقلة تمامًا.

ونتيجة لذلك، استقال 12 موظفًا في Google احتجاجًا لهذا الأمر ووقع 4000 آخرون على عريضة يُطالبون فيها الشركة بالتخلي عن العقد مع الجيش وترك مشروع Project Mayen الى الأبد.

وأحدثت هذه الحادثة ثورة على مستوى العلماء المختصين في مجالات الذكاء الاصطناعي والأخلاق التكنولوجية ووجهوا العديد من الرسائل إلى Google، يطلبون فيها من الشركة التخلي عن المشروع ودعم إتفاقية دولية من شأنها حظر الأسلحة المستقلة.

2. التطوير المتحيز

حتى لو لم يقصد مطورو خوارزميات تعلم الآلة أي ضرر في تطويرهم للخوارزميات وتعزيزها، فإن الكثير منهم ما زالوا يرغبون في جني الأموال فقط، هذا يعني أن كل الخوارزميات الخاصة بهم تم إنشاؤها لصالحهم ولجني الكثير من الأموال وليس بالضرورة لصالح المجتمع. قد توصي بعض الخوارزميات الطبية بعلاجات باهظة الثمن بدلًا من العلاجات التي تحقق أفضل نتائج للمرضى.

أحيانًا لا يهتم المطورون بأن تكون الخوارزمية نموذجًا أخلاقيًا، على سبيل المثال يمكن التخفيض من معدل الوفيات الناجمة عن حوادث المرور من خلال برمجة السيارات الذاتية القيادة بحيث لا تزيد سرعتها عن 15 ميلًا في الساعة في الطرق الخطرة، وهو ما يضمن تقريبًا خفض عدد الوفيات على الطرق إلى الصفر، ولكنه قد يلغي الفوائد الأخرى لاستخدام السيارة و بهذا يسبب أضرار للمبرمجين نفسهم.

3. معايير الأنظمة غير الأخلاقية

افتراضيًاا، لا تعرف أجهزة الكمبيوتر شيئًا عن الأخلاق، يمكن للخوارزمية أن تضع ميزانية وطنية بهدف زيادة الناتج المحلي الإجمالي وإنتاجية العمل إلى أقصى حد، ولا يمكنها وضع أي حدود أخلاقية في النموذج والشيفرات، قد يؤدي هذا الأمر الى إلغاء ميزانيات المدارس وجمعيات رعاية العجزة والبيئة، لأنها ببساطة لا تزيد من الإنتاجية المحلية الإجماية بشكل مباشر.

ولأغراض أوسع، قد تقرر زيادة الإنتاجية أيضًا عن طريق التخلص من أي شخص غير قادر على العمل، والحقيقة هي أن القضايا الأخلاقية تحتاج إلى التكامل منذ البداية.

4. النسبية الأخلاقية

الأخلاق تتطور مع مرور الوقت، وأحيانًا تتغير بسرعة فائقة، يمكن أن تتغير وجهات النظر حول قضايا مثل مغايري الهوية والزواج بين الأعراق أو بين الثقافات بشكل كبير في جيل واحد.

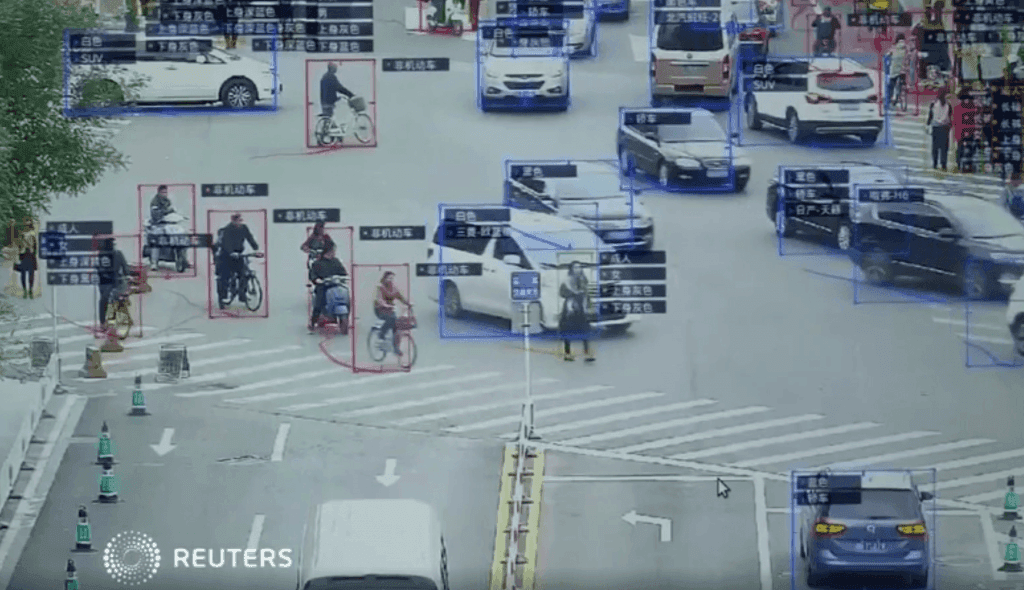

كما يمكن أن تختلف الأخلاقيات من مجموعة إلى أخرى داخل نفس البلد، بل وأكثر من ذلك في بلدان مختلفة، في الصين أصبح استخدام التعرف على الوجه للمراقبة الجماعية هو قاعدة لا يمكن الاستغناء عنها، على عكس البلدان الأخرى التي لها وجهة نظر مختلفة في هذه المسألة.

5. تعلم الآلة يغير البشر

أنظمة تعلم الآلة مجرد مثال واحد من الأمثلة الكثيرة للذكاء الاصطناعي الذي يؤثر على الأشخاص بشكل مباشر ومخيف جدًا، قد يكون هذا المثال بسيط ولكنه يلخص المقصود تمامًا، دائمًا ما تكون تشاهد أفلامك المفضلة على منصة ما وتُقابلك اقتراحات لمشاهدة أفلام جديدة مقاربةً نوعًا ما لأفكار وأنواع الأفلام المفضلة لديك، يحدث ذلك من خلال خوارزميات مبرمجة تقوم بمراجعة تقييماتك للأفلام التي شاهدتها سابقًا وتوجهك لمشاهدة أفلام أخرى جديدة، قد يُعجبك الأمر في البداية لأنه يُوفر عليك الكثير من الوقت لإيجاد أفلام جديدة تتوق لمشاهدتها والاستمتاع بها بما أنها من النوع المفضل لديك، ولكن هل يبقى الأمر هكذا أم يتغير بالتدريج؟

يقوم نظام التوصية بالأفلام بتغيير تفضيلاتك بمرور الوقت ويُضيقها في بعض الأحيان، ستجد نفسك تشاهد أفلامًا لم تتوقع أبدًا أن تُشاهدها في يوم من الأيام، ومن المثير للاهتمام أيضًا أننا لا نلاحظ حتى كيف يتم التلاعب بنا بواسطة هذه الخوارزميات المغيرة للبشر، حقًا إنه أمر مقلق للغاية!

6. العلاقات الكاذبة

يحدث الارتباط الخاطئ عندما تظهر الأشياء المستقلة تمامًا عن بعضها البعض سلوكًا مشابهًا جدًا، مما قد يخلق الوهم بأنهم متصلون بطريقة ما.

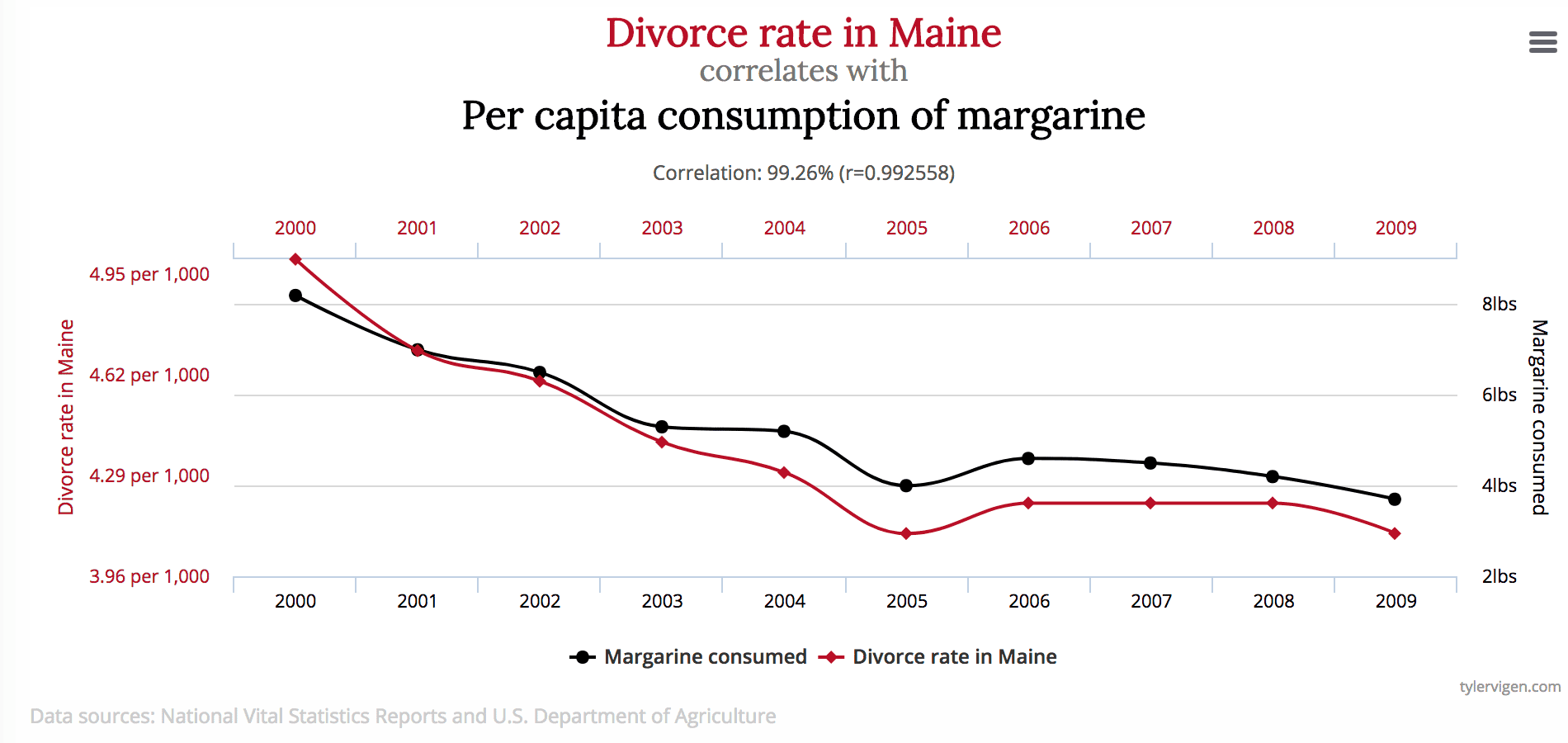

على سبيل المثال، هل تعلم بأن استهلاك الزبدة النباتية في الولايات المتحدة له ارتباط وثيق بمعدل الطلاق في ولاية Maine؟

بطبيعة الحال، فإن الأشخاص الحقيقيين الذين يعتمدون على خبرتهم الشخصية وذكائهم البشري، سوف يدركون على الفور أن وجود صلة مباشرة بين الاثنين أمر مستبعد للغاية، حيث لا يمكن للنموذج الرياضي امتلاك مثل هذه المعرفة، فهو محتوى لتعلم وتعميم البيانات فقط.

ومن الأمثلة المعروفة على ذلك، البرنامج الذي صنّف المرضى وفقًا لقسم الطوارئ من حاجتهم للمساعدة الطبية، وخَلُص إلى أن مرضى الربو الذين يعانون من الالتهاب الرئوي لا يحتاجون إلى قدر المساعدة المقدمة للمرضى الذين لا يعانون من الربو، وأظهر البرنامج من خلال بياناته أن مرضى الربو كانوا أقل عرضة لخطر الموت، وبالتالي لا ينبغي إعطاءهم الأولوية.

في الواقع، كانت معدلات وفياتهم منخفضة جدًا لأنهم تلقوا دائمًا مساعدة عاجلة من المرافق الطبية بسبب المخاطر الكبيرة الملازمة لحالتهم.

7. حلقات التغذية الراجعة (Feedback loops)

حلقات التغذية الراجعة أسوأ من الارتباطات الزائفة بكثير، فهي حالة تُؤثر فيها القرارات الخوارزمية على الواقع والذي بدوره يُقنع الخوارزمية بأن استنتاجها صحيح.

على سبيل المثال، اقترح برنامج ذكاء اصطناعي خاص بمنع الجرائم في كاليفورنيا أن ترسل الشرطة المزيد من الضباط إلى الأحياء الأمريكية الأفريقية، بناءً على معدل الجرائم المتزايد، لكن المزيد من سيارات الشرطة في الحي أدى إلى إبلاغ السكان المحليين عن الجرائم بشكل أكبر، مما أدى إلى زيادة عدد البروتوكولات والتقارير المكتوية من طرف الضباط، وبالتالي ارتفاع معدل الجريمة من جديد وإرسال عدد أكبر من الضباط على غير العادة، هذا يعني أنها حلقة مفرغة.

8. البيانات المرجعية “ملوثة” أم “مسمومة”

تعتمد نتائج تعلم الخوارزمية بشكل كبير على البيانات المرجعية والتي تُشكل أساس التعلم، ومع ذلك يُمكن أن تكون هذه البيانات سيئة وملوثة، إما عن طريق الصدفة أو عن طريق شخص ما وعادة ما يشار إليها باسم “التسمم البياناتي”.

هنا مثال عن تعرّض بيانات التعلم الآلي للتسمم، يعالج النموذج الرياضي في مختبر ما لتحليل فيروسات الكمبيوتر وسطيًا مليون ملف يوميًا، نظيفًا كان أو ضارًا، تتغير التهديدات والمشاكل باستمرار، لذلك تتم تغييرات على مستوى النموذج الرياضي للمنتجات المثبتة عند العملاء في شكل تحديثات لقاعدة بيانات مكافحة الفيروسات.

يمكن أن يستمر القراصنة في إنشاء ملفات ضارة مشابهة جدًا لتلك الملفات الخاصة وإرسالها إلى المختبر، هذا الإجراء يمحو تدريجيًا الحدود بين الملفات النظيفة والضارة، ويدمر جميع خوارزميات النموذج وربما يؤدي إلى ظهور نتائج كاذبة.

9. الخداع

حتى النموذج الرياضي الذي يعمل بشكل جيد (النموذج الذي يعتمد على بيانات جيدة) لا يزال من الممكن خداعه، إذا كان المرء يعرف آلية عمله.

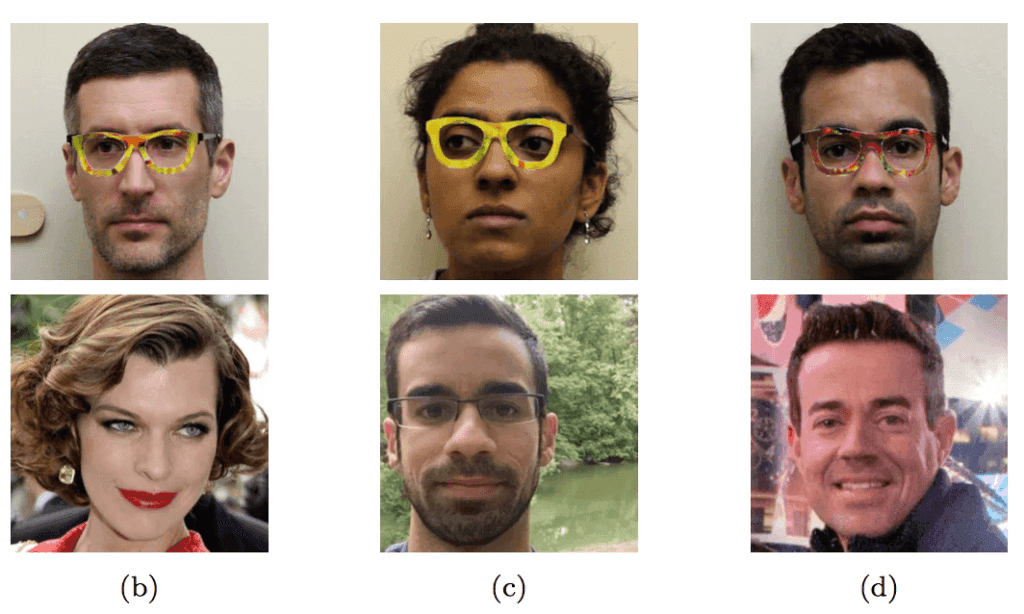

توصلت مجموعة من الباحثين إلى كيفية خداع خوارزمية التعرف على الوجه باستخدام نظارات خاصة من شأنها إحداث تشوهات للبيانات المرسلة الى المستشعر وبالتالي تغيير النتيجة تمامًا، كما يظهر في الصور أدناه تمكن هؤلاء الباحثون من خداع التكنولوجيا وتم تعريفهم على أنهم أفراد آخرون لا يشبهونهم إطلاقًا، حتى في الحالات التي تبدو معقدة نوعًا ما، يُمكن بسهولة خداع الجهاز باستخدام أساليب غير معروفة للشخص العادي.

طالما أن البشرية لا تزال أذكى من معظم الخوارزميات، فسيكون بمقدور البشر خداعها دائمًا، عندما نفكر في تعلم الآلة وفي المستقبل القريب الذي يحلل صور الأشعة السينية للأمتعة في المطار ويبحث عن الأسلحة، سيتمكن الإنسان الذكي من وضع جسم ذي شكل معين وبرمجة تحجب السلاح، وبالتالي جعل المسدس غير مرئي.

على من يقع اللوم يا ترى؟

لا يمكن أن نوجه اللوم على أي أحد فلكل شخص أسبابه ومحفزاته الخاصة، في هذه المرحلة الحساسة والاستثنائية المقبلة على وجهة جديدة مليئة بالتحديات والحواجز الصعبة، لذلك علينا اعتماد قوانين جديدة وافتراض خوارزميات أخلاقية للروبوتات وللأجهزة الإلكترونية.

في مايو 2018 اتخذت ألمانيا أول خطواتها في هذا الاتجاه وأصدرت قواعد أخلاقية للسيارات ذاتية القيادة وبذلك ساعدت البشرية وأنقذت العديد من الأرواح وفرضت برمجيات فيها نوع من الأخلاقيات التي نحتاجها بشدة في وقتنا هذا.

من الواضح أننا سوف نعتمد على التعلم الآلي أكثر فأكثر، لأنه ببساطة سيدير العديد من المهام بشكل أفضل مما تستطيع البشرية القيام به، لنتدارك كل هذه الأمور من المهم أن نضع كل العيوب والمشكلات المحتملة في الاعتبار وأن نحاول توقع جميع التعقيدات المحتملة في مرحلة التطوير. نعم بالفعل مستقبلنا متعلق بحسن إدارتنا لتعلم الآلة، فإذا أردنا أن نحظى بمستقبل جميل، يجب أن نتعامل مع التكنولوجيا بعقلانية لكي نتحكم بها ولا نتركها تتحكم بنا!

أحلى ماعندنا ، واصل لعندك! سجل بنشرة أراجيك البريدية

بالنقر على زر “التسجيل”، فإنك توافق شروط الخدمة وسياسية الخصوصية وتلقي رسائل بريدية من أراجيك

عبَّر عن رأيك

إحرص أن يكون تعليقك موضوعيّاً ومفيداً، حافظ على سُمعتكَ الرقميَّةواحترم الكاتب والأعضاء والقُرّاء.